Причины почему Google не индексирует сайт

Продвижение в поиске не работает без полноценной индексации, поэтому если система не добавляет веб-ресурс в свой каталог, необходимо найти причину и устранить её.

В статье мы пошагово проанализируем все факторы, которые могут помешать Google проиндексировать ваш сайт. Покажем, как устранить проблемы.

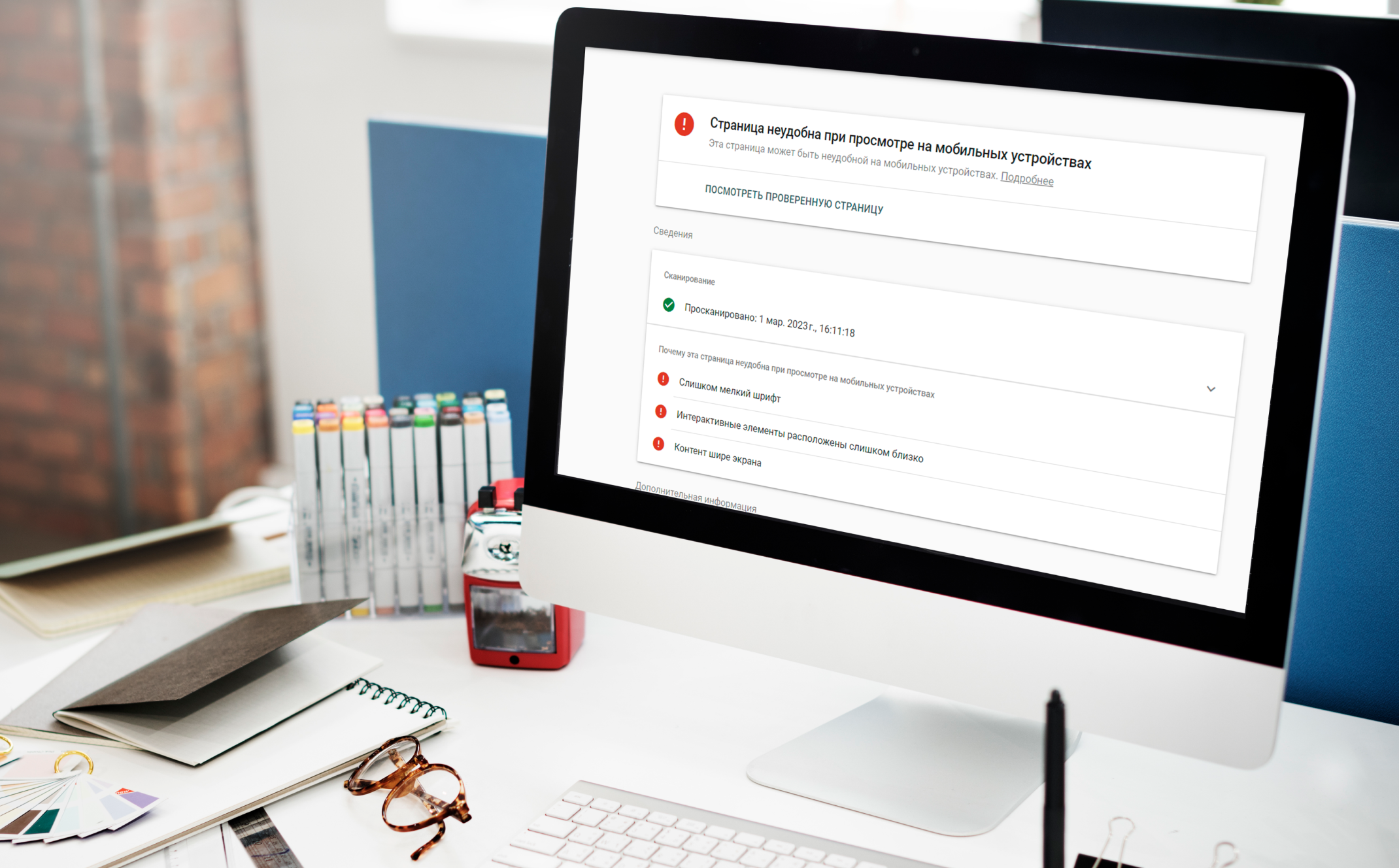

Нет мобильной адаптации

Начиная с 2019 года, при индексации отдается приоритет мобильной версии. Важно при вёрстке макета адаптировать его под определённые устройства: ПК, ноутбук, мобильный телефон, планшет. Иначе вы попадёте в ситуацию: поисковая система будет низко ранжировать ваш ресурс, а приоритет будут получать сайты оптимизированные для мобильных устройств.

Узнать насколько хорошо адаптирована мобильная версия, можно, если воспользоваться специальным инструментом — Google Search Console. Необходимо ввести URL и нажать кнопку «Проверить страницу».

Узнать насколько хорошо адаптирована мобильная версия, можно, если воспользоваться специальным инструментом — Google Search Console. Необходимо ввести URL и нажать кнопку «Проверить страницу».

Много дублированного контента

Дубли страниц, метатегов, текстового и графического наполнения могут стать причиной отсутствия индексации и попадания под поисковые санкции. Выбраться из бана бывает очень трудно, поэтому необходимо сделать всё, чтобы веб-ресурс под него не попал.

Чаще всего поисковик банит из-за следующих проблем:

Чаще всего поисковик банит из-за следующих проблем:

-

вредоносное программное обеспечение;

-

большое количество скрытого текста и ссылок;

-

многочисленная переадресация и цепочки редиректов;

-

нерелевантные ключевые слова или их переспам;

-

повторяющийся контент.

Необходимо устранить все нарушения и только после этого отправлять страницы сайта на переиндексацию.

Неправильное техническое SEO

Техническая оптимизация — обязательная составляющая для правильного индексирования, сканирования портала. С помощью её грамотного выполнения можно найти основные проблемы и устранить их.

Для того, чтобы таких проблем не возникало, маркетинговое агентство IZIFIR еще на этапе проектирования и создания структуры сайта, привлекает SEO-специалиста. Важно предупредить возможность появления таких проблем, чтобы не пришлось тратить время на их решение в дальнейшем, переделку.

Для того, чтобы таких проблем не возникало, маркетинговое агентство IZIFIR еще на этапе проектирования и создания структуры сайта, привлекает SEO-специалиста. Важно предупредить возможность появления таких проблем, чтобы не пришлось тратить время на их решение в дальнейшем, переделку.

Использование JavaScript для рендеринга

В ходе преобразования кода в картинку часто используют JavaScript, что само по себе не несёт проблем с индексацией. Однако они могут возникнуть, если используется маскировка. Скрытие файлов не поможет.

При маскировке пользователям и поисковым системам предлагают разный контент и ссылки на страницы.

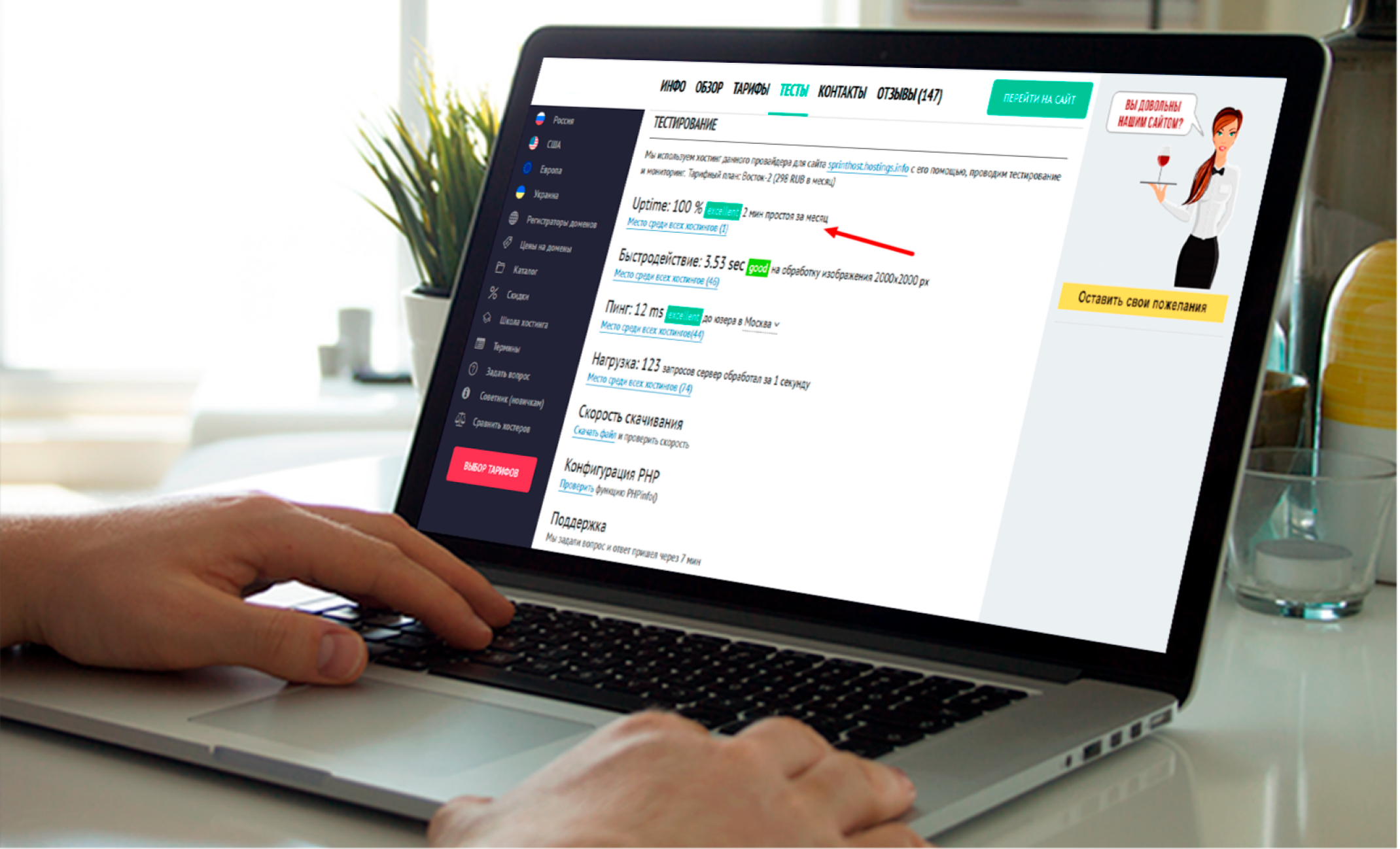

Неправильная работа хостинга или сервера

Не должно быть ситуаций, когда поисковой робот придёт на страницу и откажет в индексации из-за недоступности сайта. Заранее позаботьтесь о том, чтобы у сервера был стабильный up time. Это можно проверить любым сервисом по мониторингу.

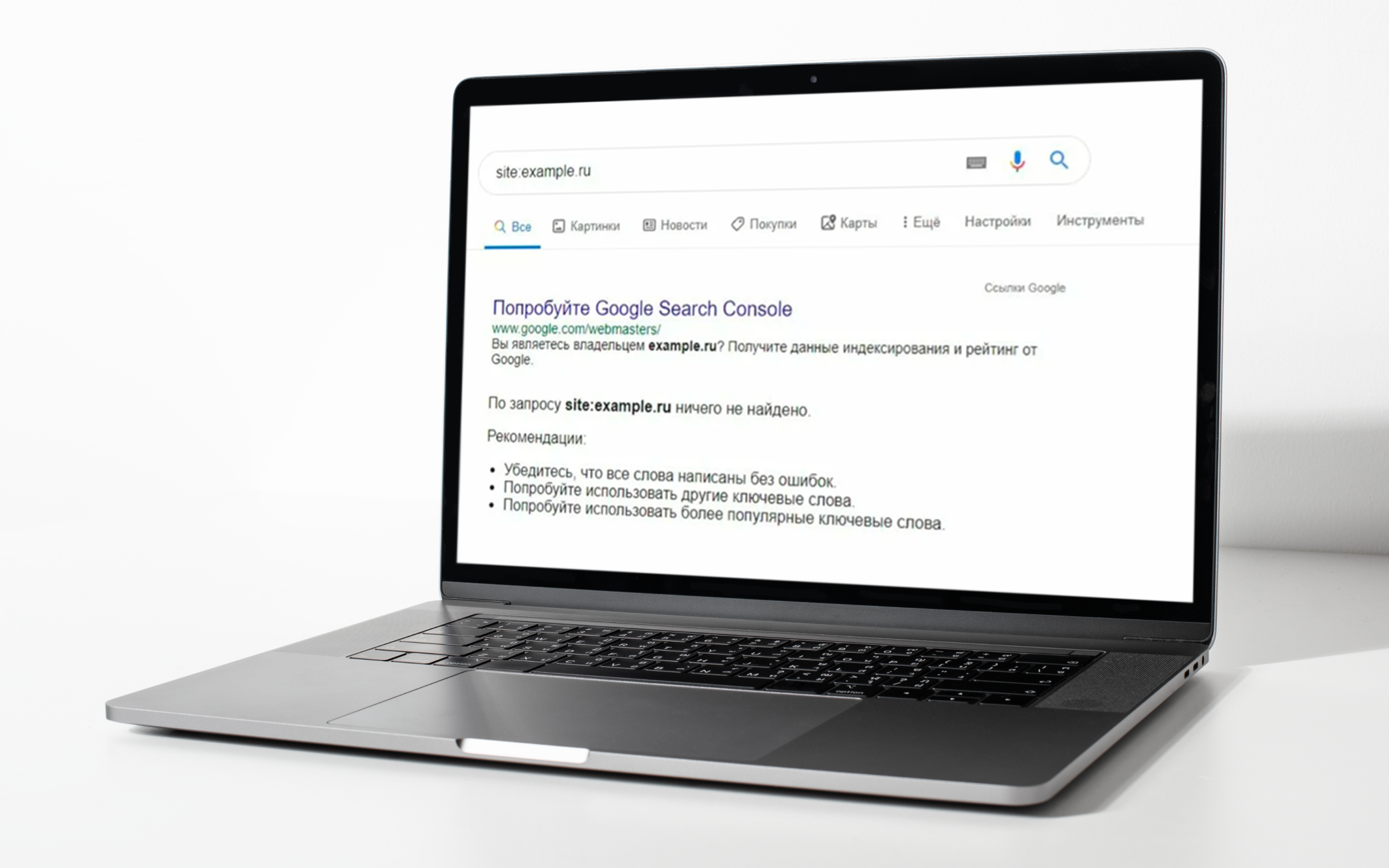

Домен попал в бан

Даже если вы зарегистрировали хороший домен, проверили ссылки, сайт имеет уникальный контент и хороший дизайн, но не хочет индексироваться, то возможно дело в этом.

Чтобы исключить такую вероятность, необходимо написать в поддержку Яндекс Вебмастер и оставить свой запрос на форуме Google для вебмастеров, после чего начать усилённо развивать проект. Обычно если в течение 3-4 месяцев ничего не меняется, то рекомендуем начать использовать другой домен или переклеить сайт на новое доменное имя.

Чтобы исключить такую вероятность, необходимо написать в поддержку Яндекс Вебмастер и оставить свой запрос на форуме Google для вебмастеров, после чего начать усилённо развивать проект. Обычно если в течение 3-4 месяцев ничего не меняется, то рекомендуем начать использовать другой домен или переклеить сайт на новое доменное имя.

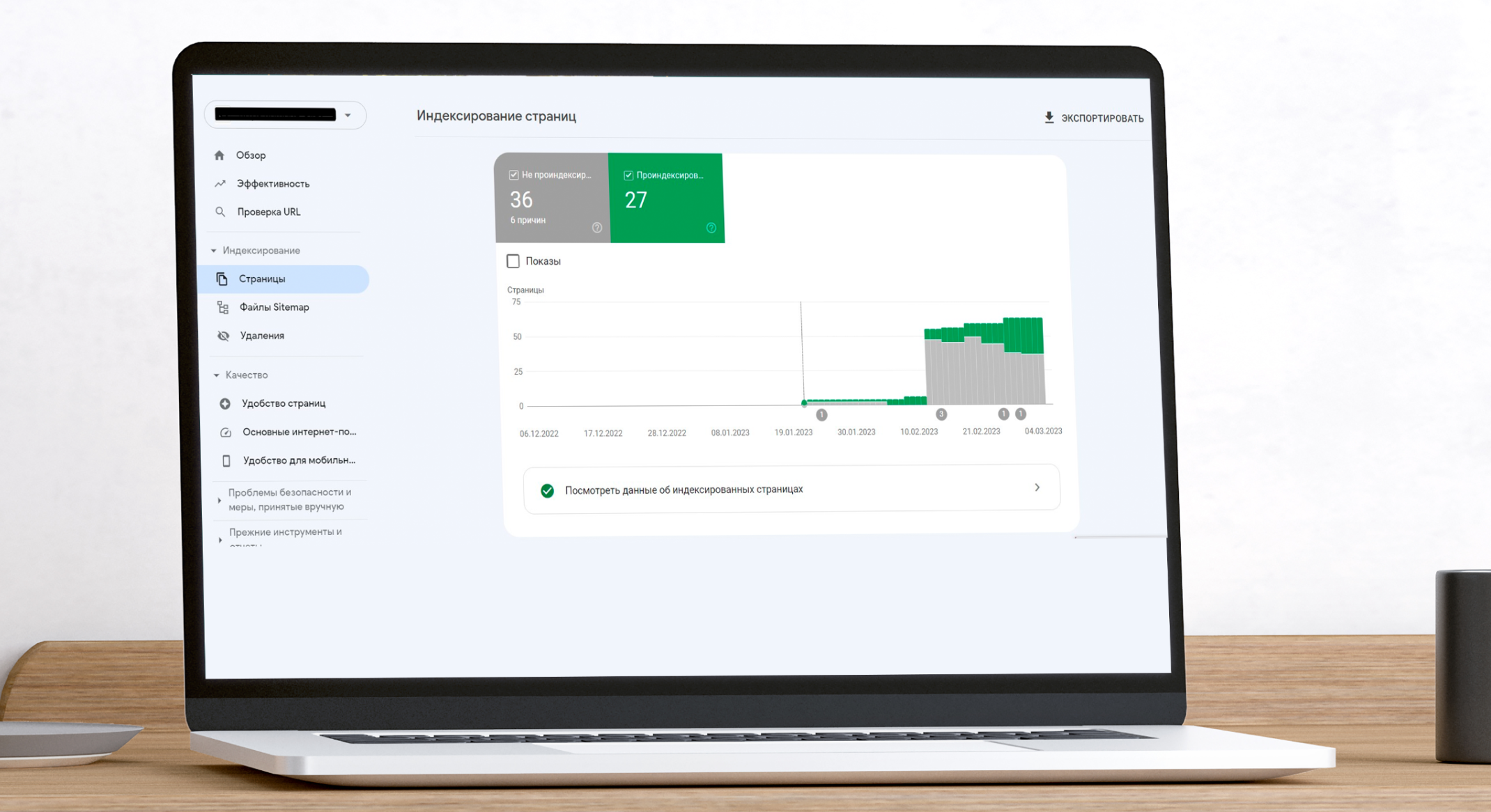

Ошибки сканирования

Многочисленные ошибки сканирования затрудняют путь робота к определённым страницам. Для проверки этой причины выполните следующие действия: зайдите в Google Search Console, кликните на «Сканирование» и смотрите результат.

Если обнаружены критические ошибки, то необходимо их исправить.

Если обнаружены критические ошибки, то необходимо их исправить.

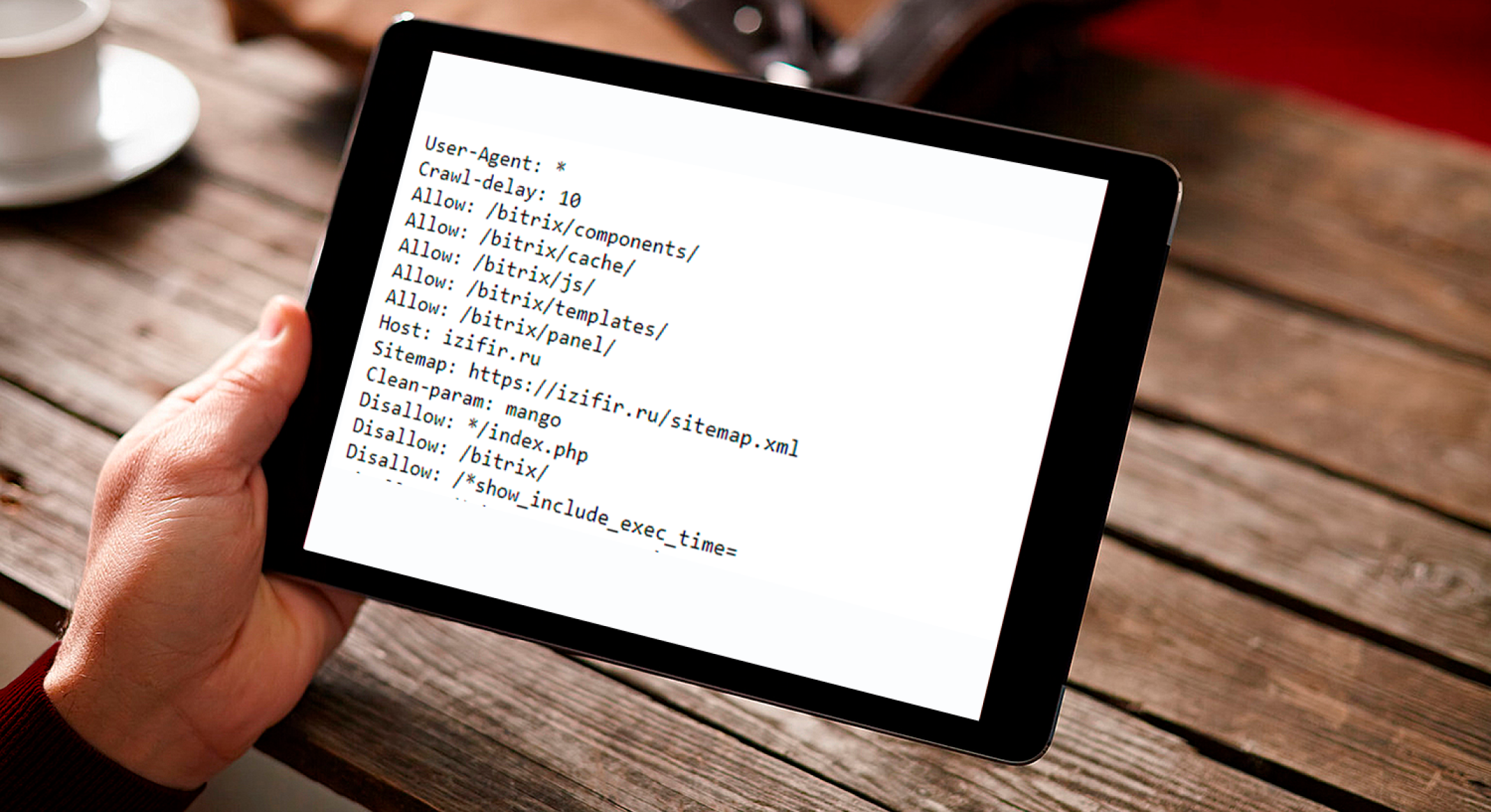

Страницы сайта или полностью весь портал закрыты в robots.txt

Обычно разработчики сдают сайт закрытым от индексации в файлах robots.txt. Это легко поправить, если следовать инструкции:

-

Найти путь к файлу: он выглядит примерно так https://izifir.ru/robots.txt. Необходимо к URL подставить название файла “/robots.txt”.

-

В коде будут прописаны директивы, которые помогают роботам понять какие страницы индексировать, а какие не нужно: . Disallow — запрещает индексацию, а Allow — разрешает.

-

Здесь необходимо прописать правильный сценарий и оставить для индексации только нужные страницы.

Если вы новичок в этом, рекомендуем обратиться к специалистам, которые за несколько минут вернут портал к индексации.

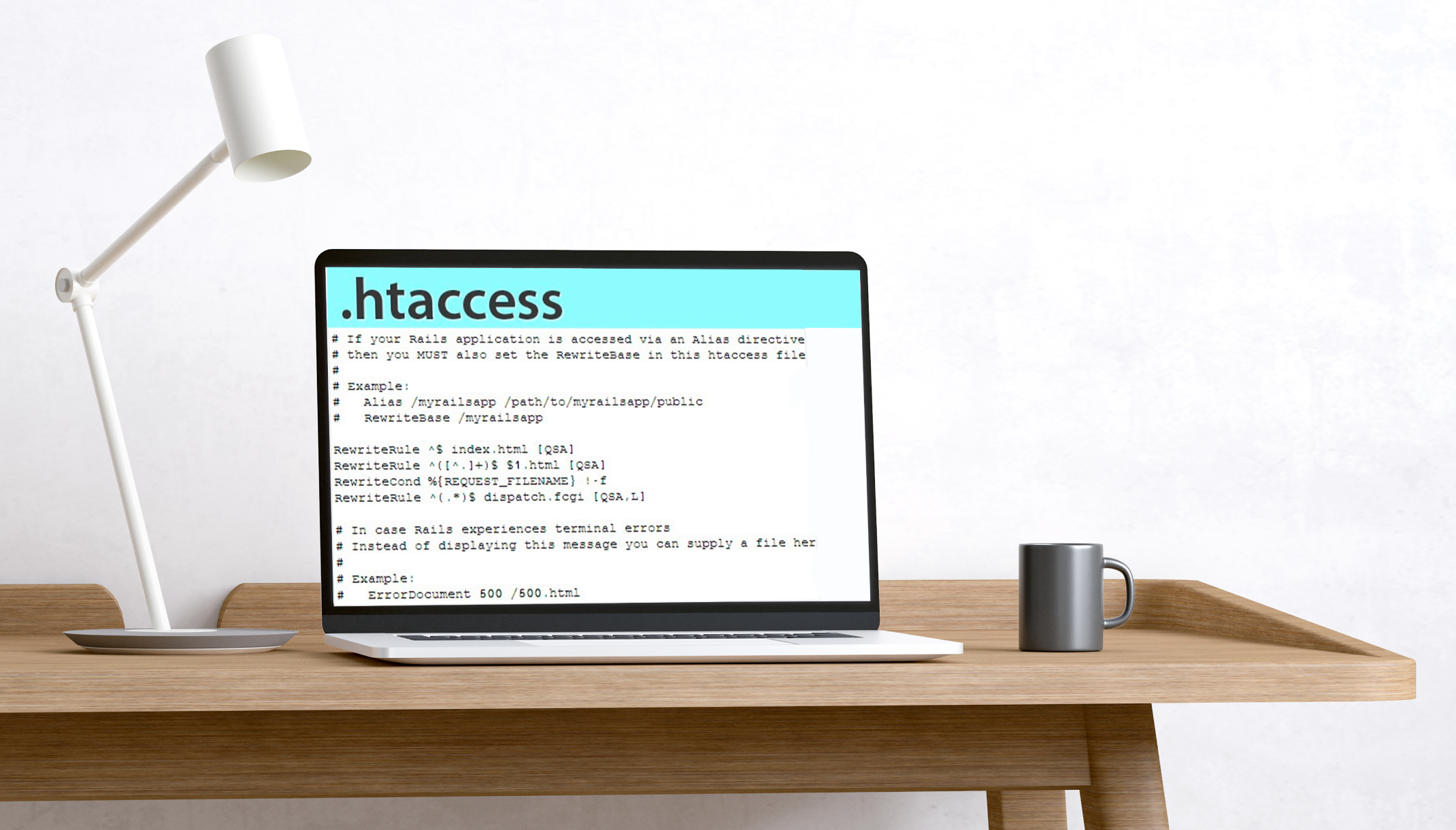

Блокировка сайта в .htaccess

С помощью этого файла тоже можно закрыть сайт от поисковых систем. Для того, чтобы проверить этот момент, следует найти его на сервере и посмотреть в коде изменения.

Лучше всего обратиться к разработчикам, которые делали веб-ресурс и попросить проверить их.

Лучше всего обратиться к разработчикам, которые делали веб-ресурс и попросить проверить их.

Бесконечный цикл переадресации

Это тоже может быть серьёзной причиной для закрытия веб-портала от поиска. Здесь поможет файл .htaccess. Необходимо его найти и вставить Redirect 301 для обнаружения команд с перенаправлением.

Дополнительные ошибки можно найти при помощи инструмента Screaming Frog. После их устранения, обратитесь еще раз с запросом в Google.

Дополнительные ошибки можно найти при помощи инструмента Screaming Frog. После их устранения, обратитесь еще раз с запросом в Google.

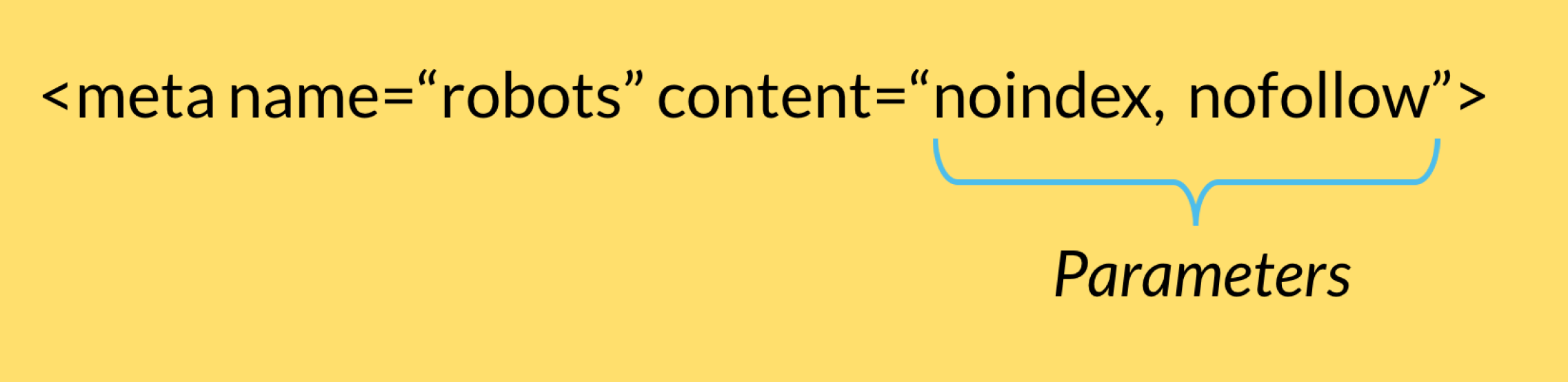

Есть метатеги noindex, nofollow

Эти метатеги нужны в некоторых случаях. Но иногда бывает так, что они ставятся не на той странице или применены ко всему веб-ресурсу. В таком случае индексации не будет.

Если вы обнаружили их наличие, то просто замените их на другие: index, follow.

Если вы обнаружили их наличие, то просто замените их на другие: index, follow.

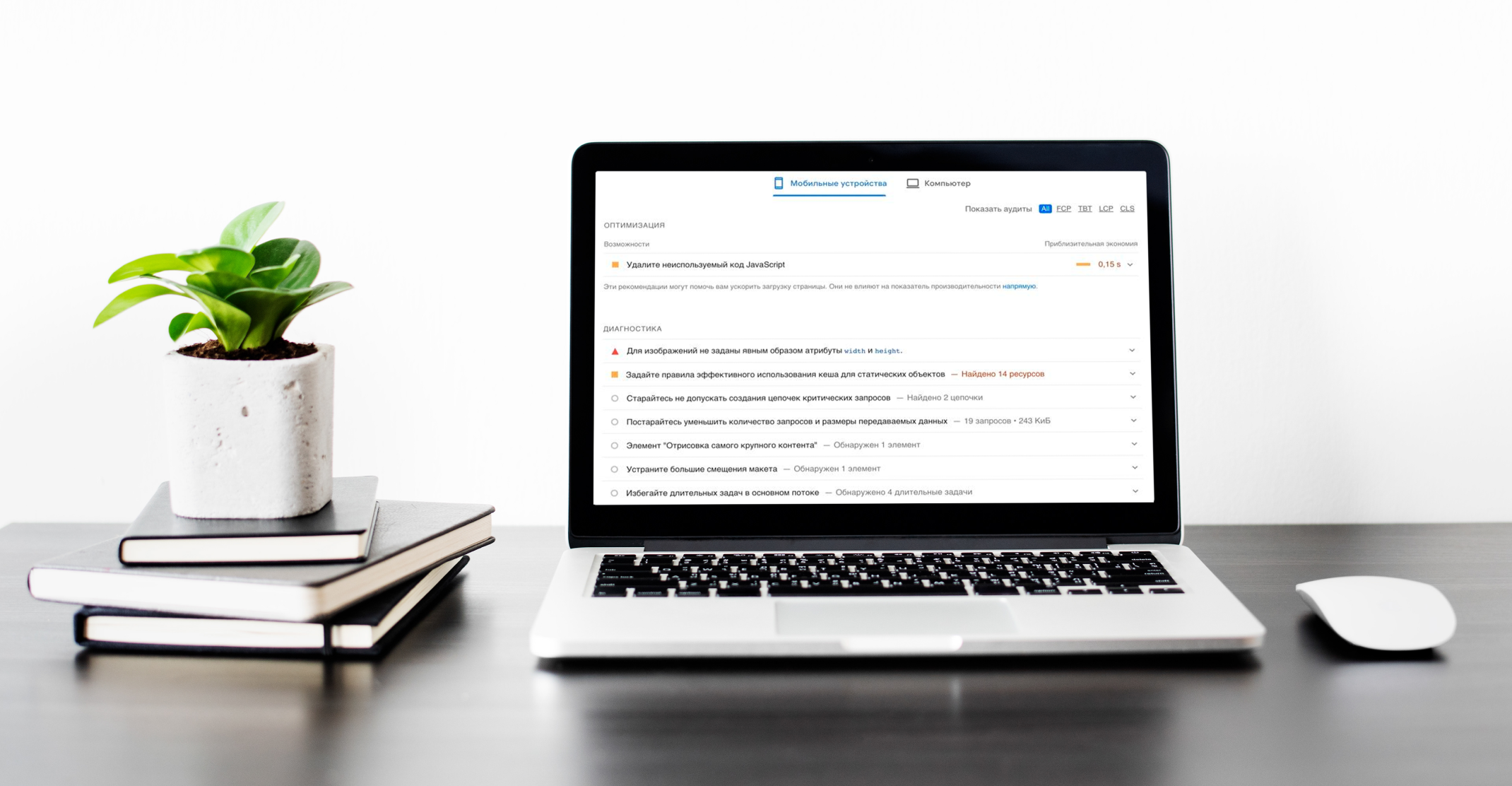

Сайт долго грузится

Порталы с длительной загрузкой индексируются хуже. У медленной загрузки есть много причин, но определить насколько хорошо ресурс работает можно несколькими инструментами:

-

PageSpeed Insights (хорошо анализирует скорость и предоставляет рекомендации по оптимизации).

-

WebPageTest (показывает скорость и элементы, которые её снижают).

Чтобы сайт успешно продвигался, важно размещать на нем качественный контент, работать с технической оптимизацией и создавать правильные обратные ссылки. Перед этим следует убедиться, что портал правильно индексируется. В противном случае все усилия для продвижения уйдут в никуда.

Если у сайта внезапно упал трафик, выросли отказы или он перестал приносить прибыль, обратитесь к нам. Специалисты агентства проведут технический и маркетинговый аудит и помогут найти проблему.

Содержание

Нет мобильной адаптации

Много дублированного контента

Неправильное техническое SEO

Использование JavaScript для рендеринга

Неправильная работа хостинга или сервера

Домен попал в бан

Ошибки сканирования

Страницы сайта или полностью весь портал закрыты в robots.txt

Блокировка сайта в .htaccess

Бесконечный цикл переадресации

Есть метатеги noindex, nofollow

Сайт долго грузится

Оставьте отзыв

Acme

14.10.2023

Как много «старичков»...

Другие статьи

07.02.2023

5

0

1152

11 мин

Макс

15.10.2023